python3 requests库实现多图片爬取教程

作者:small_brother 发布时间:2023-11-22 15:37:40

最近对爬虫比较感兴趣,所以就学了一下,看人家都在网上爬取那么多美女图片养眼,我也迫不及待的试了一下,不多说,切入正题。

其实爬取图片和你下载图片是一个样子的,都是操作链接,也就是url,所以当我们确定要爬取的东西后就要开始寻找url了,所以先打开百度图片搜一下

然后使用浏览器F12进入开发者模式,或者右键检查元素

注意看xhr,点开观察有什么不一样的(如果没有xhr就在网页下滑)

第一个是这样的

第二个是这样的

注意看,pn是不是是30的倍数,而此时网页图片的数量也在增多,发现了这个,进url看一下,首先看原网页源码

view-source:http://image.baidu.com/search/index?tn=baiduimage&ipn=r&ct=201326592&cl=2&lm=-1&st=-1&fm=index&fr=&hs=0&xthttps=111121&sf=1&fmq=&pv=&ic=0&nc=1&z=&se=1&showtab=0&fb=0&width=&height=&face=0&istype=2&ie=utf-8&word=%E7%BE%8E%E5%A5%B3&oq=%E7%BE%8E%E5%A5%B3&rsp=-1

再看看两个Requests URL的页面,发现都是这样的

不用管他,找我们要的信息,ObjURL,"ObjURL":"http:\/\/image.tianjimedia.com\/uploadimages\/2015\/131\/34\/545szi3x5s84_680x500.jpg"

就是这个,好,现在东西都找到在哪了,写程序咯

import re

import requests

import os

name=input('输入文件夹名称:')

robot='C:/Users/lenovo/Desktop/'+name+'/'

kv={'user-agent':'mozilla/5.0'}

#获取url对应的源码页面

def getHTMLText(url):

try:

r=requests.get(url,timeout=30,headers=kv)

r.raise_for_status()

r.encoding=r.apparent_encoding

return r.text

except:

return ''

#解析url源码页面

def parserHTML(html):

#正则表达式为获取ObjURL

pattern=r'"ObjURL":"(.*?)"'

reg=re.compile(pattern)

urls=re.findall(reg,html)

return urls

#下载图片

def download(List):

for url in List:

try:

path=robot+url.split('/')[-1]

url=url.replace('\\','')

r=requests.get(url,timeout=30)

r.raise_for_status()

r.encoding=r.apparent_encoding

if not os.path.exists(robot):

os.makedirs(robot)

if not os.path.exists(path):

with open(path,'wb') as f:

f.write(r.content)

f.close()

print(path+' 文件保存成功')

else:

print('文件已经存在')

except:

continue

#通过Requests URL请求到更多的url源码页面

def getmoreurl(num,word):

ur=[]

url=r'http://image.baidu.com/search/acjson?tn=resultjson_com&ipn=rj&ct=201326592&is=&fp=result&queryWord={word}&cl=2&lm=-1&ie=utf-8&oe=utf-8&adpicid=&st=-1&z=&ic=0&word={word}&s=&se=&tab=&width=&height=&face=0&istype=2&qc=&nc=1&fr=&cg=girl&pn={pn}&rn=30'

for x in range(1,num+1):

#word为搜索关键词,num为想获取的页面数量

u=url.format(word=word,pn=30*x)

ur.append(u)

return ur

def main():

n=int(input('输入想下载多少张图片(n*30):'))

word=input('输入想下载的图片:')

#初始页面url

url='http://image.baidu.com/search/index?tn=baiduimage&ipn=r&ct=201326592&cl=2&lm=-1&st=-1&fm=result&fr=&sf=1&fmq=1499773676062_R&pv=&ic=0&nc=1&z=&se=1&showtab=0&fb=0&width=&height=&face=0&istype=2&ie=utf-8&word={word}'.format(word=word)

html=getHTMLText(url)

urls=parserHTML(html)

download(urls)

#下面操作获取的更多页面图片

url1=getmoreurl(n,word)

for i in range(n):

html1=getHTMLText(url1[i])

urls1=parserHTML(html1)

download(urls1)

main()

然后试一试效果

我知道你们会原谅我的

来源:https://blog.csdn.net/small_brother/article/details/75003392

猜你喜欢

- 在 golang 语言中,实现io的读与写,只要实现了如下的读写接口即可:// go 1.19/src/io/io.go

- random.randomrandom.random()用于生成一个0到1的随机符点数: 0 <= n < 1.0random.

- MySQL里Create Index 能否创建主键 Primary Key? 答案: 不能,必须用 Alter table 创建。 MySQ

- Logminer是每个Dba都应熟悉的工具,当一天由于用户的误操作你需要做不完全的恢复时,由于你无法确定这个操作是哪个时间做的,所以这对你的

- 与部门同事做了个小小的交流,话题杂而浅,在此做一个小纪录。1、什么是设计工业设计、环境设计、建筑设计、平面设计、网页设计、服装设计、信息设计

- 之前的文章介绍了python抓取网页数据并将数据保存到本地excel文件,后续可以将数据保存到数据库(SqlServer、mysql等)中,

- import urllib.parse,os.path,time,sysfrom http.client import HTTPSConne

- 1. 序言每年淘宝双十一的时候,总是要刷各种各样的浏览页面,收集能量或者喵币或者什么。那既然如此,我就总想着,能否通过Python自动调用的

- DOM模型中的节点:元素节点、文本节点、属性节点 例:<a href=”http://www.cnblogs.com/shuz”>

- 1、csv文件的导入和导出 通过一个矩阵导出为csv文件,将csv文件导入为矩阵将csv文件导入到一个矩阵中import numpy my_

- 本文实例讲述了python简单猜数游戏。分享给大家供大家参考。具体实现方法如下:#!/usr/bin/env pythonimport ra

- 今天我们说一下Redis中最后一个数据类型 “有序集合类型”,回首之前学过的几个数据结构,不知道你会不会由衷感叹,开源的世界真好,写这些代码

- 之前在《首都机场的点烟器》中分析了一个软件系统所处的状态并且列举了不同的状态所需要的展示给用户的各类信息,我们先简单回顾一下:要设计一个软件

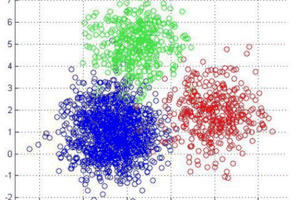

- 引言层次聚类是一种构建聚类层次结构的聚类算法。该算法从分配给它们自己的集群的所有数据点开始。然后将两个最近的集群合并到同一个集群中。最后,当

- Pytorch torch.distributions库包介绍torch.distributions包包含可参数化的概率分布和采样函数。 这

- GO的条件变量一、条件变量与互斥锁条件变量是基于互斥锁的,它必须基于互斥锁才能发挥作用;条件变量并不是用来保护临界区和共享资源的,它是用来协

- 一、原理说明1,authentication_string这是Mysql8.0新做出的修改,在旧版本中使用的是password()函数。2,

- JAVA程序想要访问数据库,需要进行如下准备:1.安装一个数据库(这里使用mysql免安装版)2.下载该数据库的驱动包(这里使用mysql官

- 在使用json.dumps时要注意一个问题>>> import json>>> print json.d

- Django自带有个强大的后天管理系统,接下来我就给大家介绍一下x的admin一些强大的操作及后台美化。首先给大家介绍一些xadmin的注册